過去にQiitaに投稿した内容のアーカイブです。

AWS Summit Online 2021が開催中です。 https://summits-japan.virtual.awsevents.com/

すごくたくさんのセッションがあるのですが、ふと、どんな分野が流行りなのかなぁと思ったのでセッションの情報を分析してみました。

使用したツール

僕にはなんにもスキルがありませんので、便利なサイトを利用させていただきました。

AIテキストマイニング by ユーザーローカル https://textmining.userlocal.jp/

データ取得方法

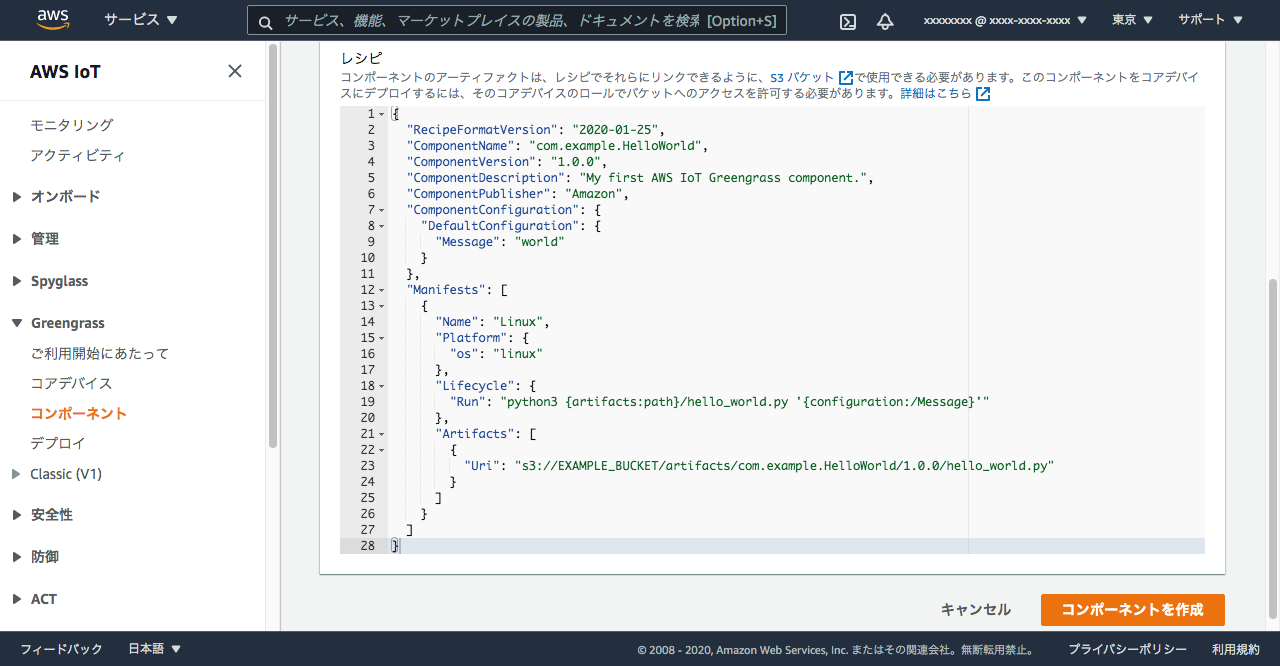

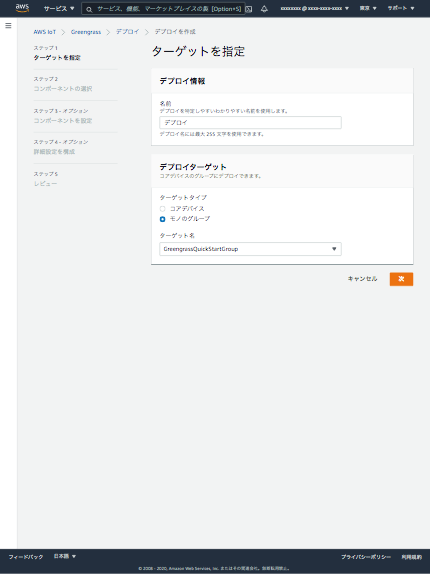

セッションの一覧ページは、こんな感じで、タイトルと説明文で構成されています。 説明文が途中で切れてますが、このまま使用しました。

Chrome DevToolsのConsoleタブで以下のコマンド実行で取得できました。

item__name = ''

document.querySelectorAll('.event-list-item__name').forEach(value => item__name = item__name + value.innerText + '\n')

item__name

copy(item__name) // クリップボードにコピー

item__description = ''

document.querySelectorAll('.event-list-item__description').forEach(value => item__description = item__description + value.innerText + '\n')

item__description

copy(item__description) // クリップボードにコピー

結果

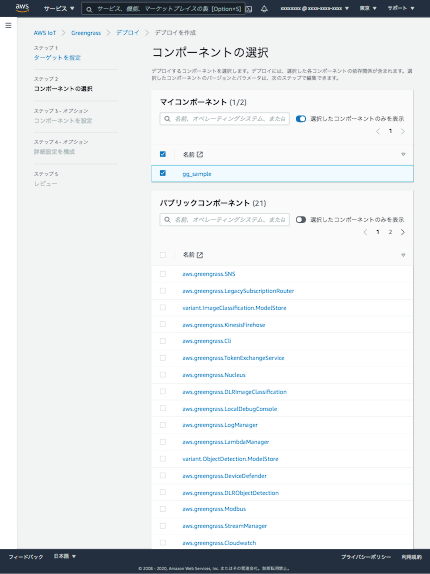

セッションがAWSセッションとパートナーセッションに分かれているのでそれぞれでやってみました。

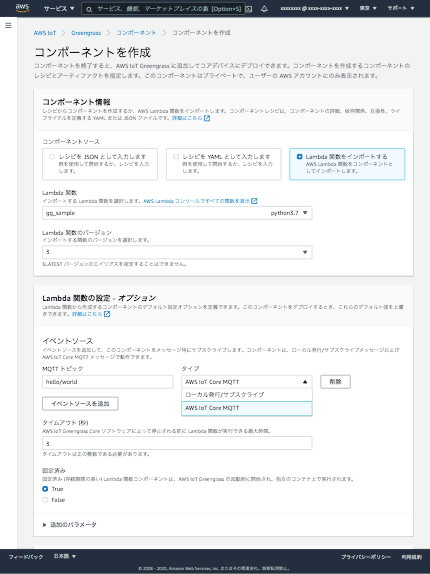

AWSセッション編

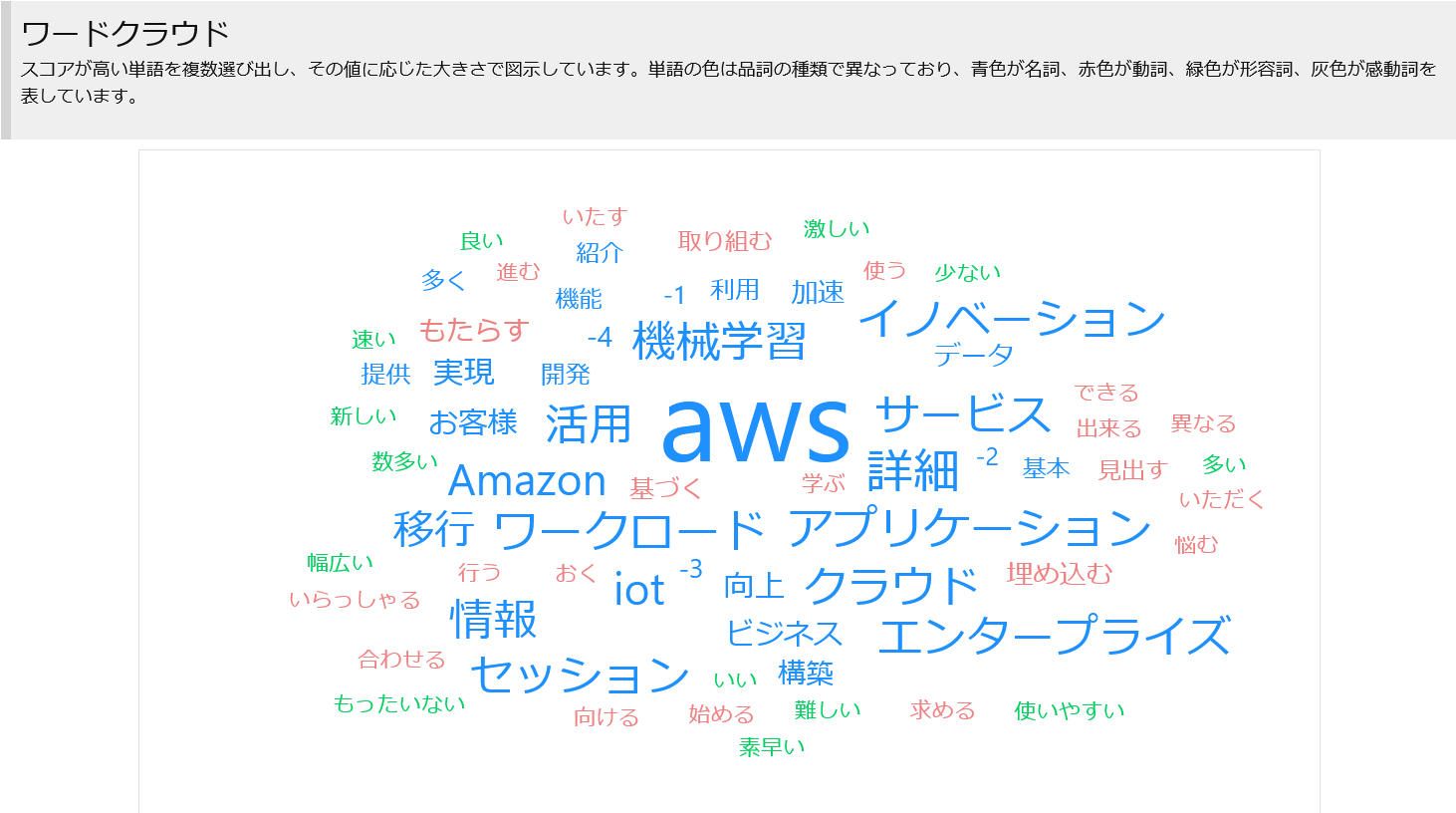

ワードクラウド

AWSは当然ですが、機械学習やワークロードなどが目を引く感じでしょうか

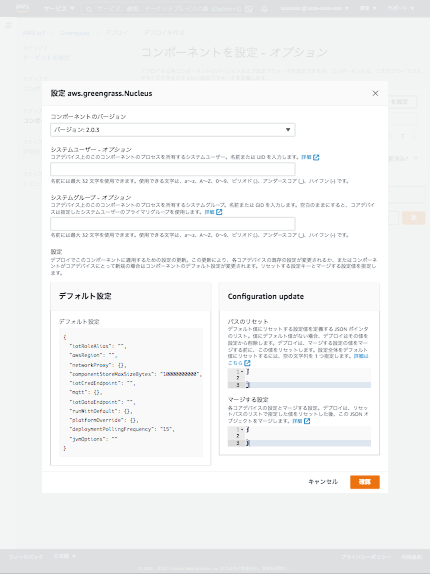

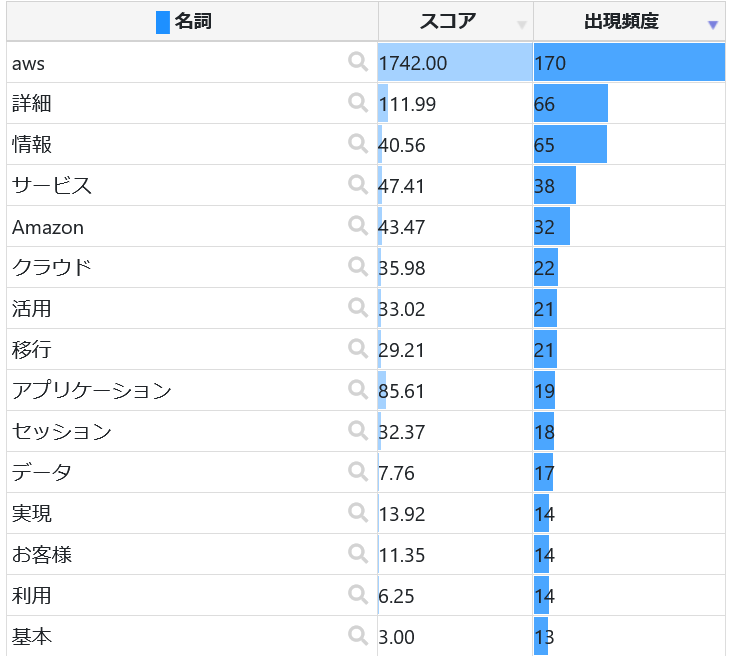

頻出単語(名詞)

先程のワードクラウドとはちょっと結果が異なる感じでしょうか。詳細や情報は説明文の末尾に必ず詳細情報とあるので、それが出てるだけと思います。

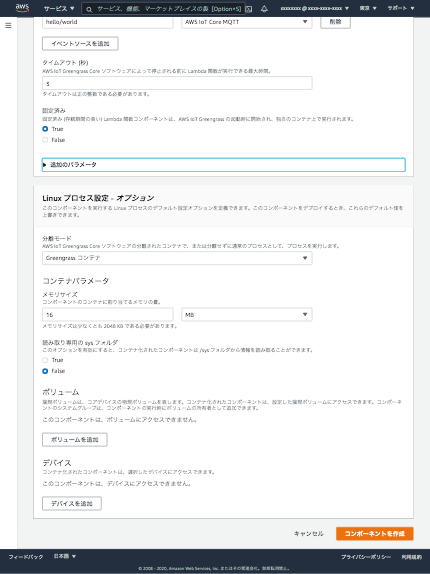

パートナーセッション編

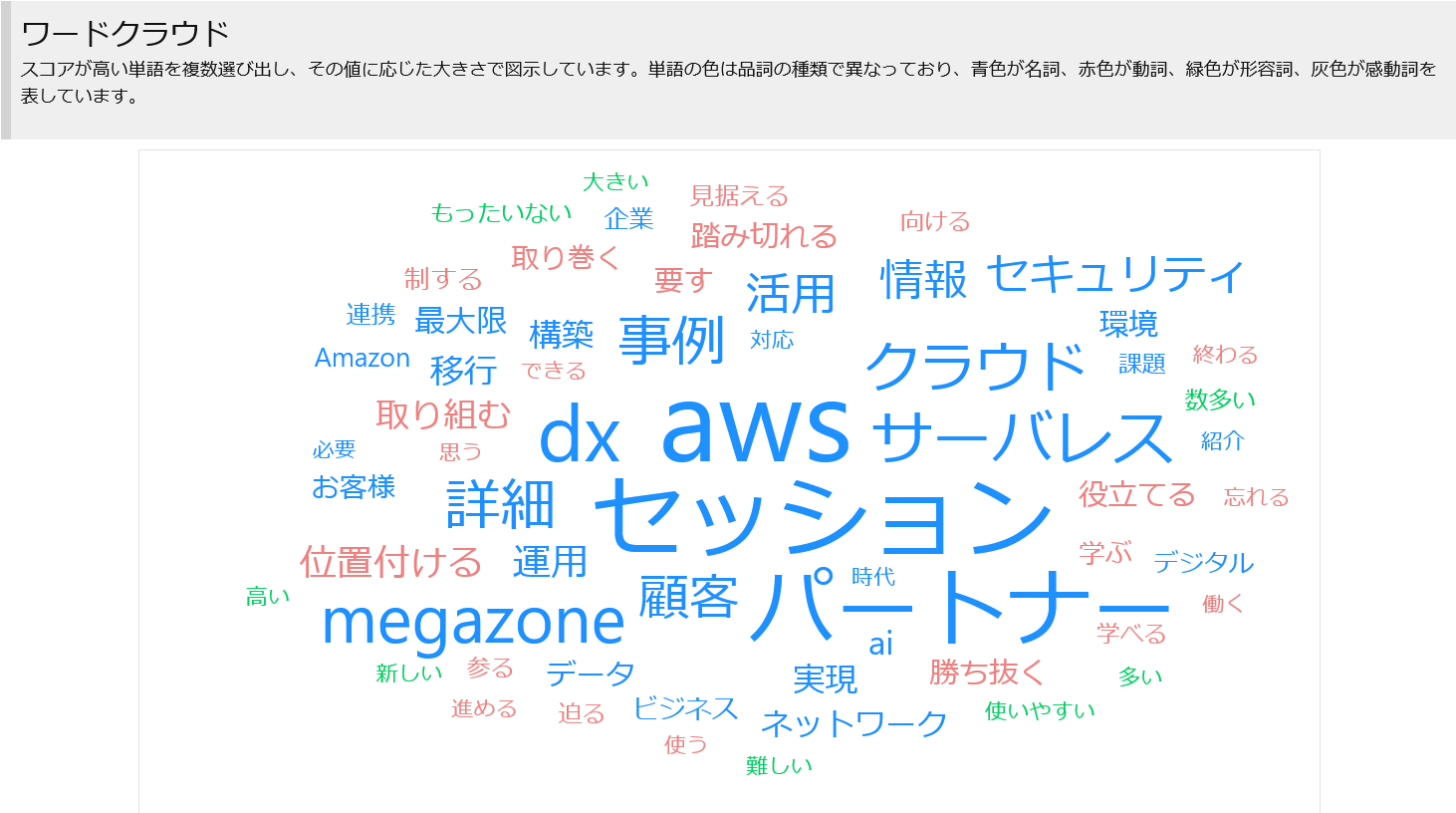

ワードクラウド

パートナーセッションだけに、パートナーの文字がでかい!!。AWSセッションとの違いではdx、サーバレスの大きさが目を引きますね。

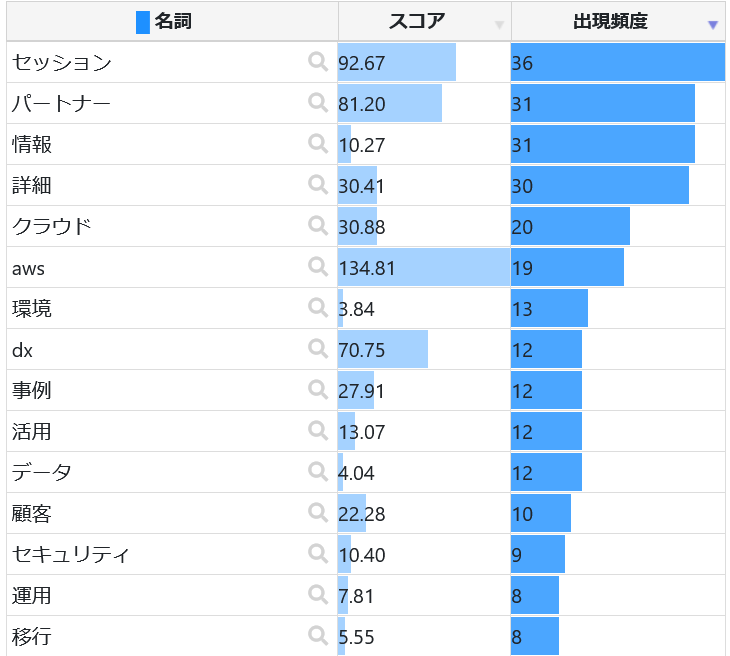

頻出単語(名詞)

セキュリティがパートナーセッションの方だけランクインですね。

以上です。